Die Kombination aus Datenskandalen, Kostenexplosionen bei Cloud-Diensten und dem Wunsch nach digitaler Souveränität treiben den Trend zum Self-Hosting oder Home-Lab an. Dank Projekten wie Nextcloud, Home Assistant, Open Media Vault, Proxmox oder TrueNAS ist Selbsthosting heute auch für Laien machbar. Kein Wunder, dass der Heimserver zum neuen DIY-Projekt avanciert. Dabei helfen Dienste wie Docker dabei, eine selbst-gehostete Anwendung schnell und vergleichsweise einfach aufzusetzen.

Eine Mischung aus Leidenschaft, Frust, Lernwillen und innerem Frieden

Auch bei mir hat sich vor immer mehr die Erkenntnis durchgesetzt, dass man vielen Diensten und Cloud-Services einfach nicht mehr trauen kann. Bestes Beispiel ist gerade wieder die Ankündigung von Mozilla, dass man das Bookmarking- und Read-It-Later-Tool Pocket zum 8. Juli einstellen wird. Ich habe es über viele Jahre genutzt, bin aber vor einiger Zeit auf Readeck umgestiegen, das auf meinem eigenen Server läuft. Der Umzug der Inhalte von Pocket zu Readeck war mit einem Klick erledigt.

Ich habe auch einige Jahre das Microsoft Office 365 Family Paket genutzt und Outlook 365 für meine Mails. Damals konnte man noch eine eigene Domain mit Outlook nutzen. Das wurde von Microsoft jedoch abgeschafft und man muss damit rechnen, dass auch Alt-Accounts das irgendwann nicht mehr nutzen können.

Eine Sache, die so viele zum Self-Hosting treibt, ist daher die zunehmende Enshittification. Dienste, auf die man Jahre vertraut hat, werden plötzlich eingestampft. Freemium-Versionen werden schrittweise bis zur Unbrauchbarkeit reduziert und die Abo-Gebühren steigen stetig. Zudem vergeht kein Tag, an dem nicht irgendein Cloud-Service gehackt wurde. Große Anbieter mit vielen Nutzern sind natürlich ein interessantes Ziel für Hacker.

Ebenfalls bemerkenswert ist die Sperre des E-Mail-Kontos des Chefanklägers des Internationalen Strafgerichtshofs durch Microsoft auf Befehl des geistigen Minderleisters im Weißen Haus. Offenbar springen die Tech-Bros, wenn das Trumpeltier möchte, dass ein digitaler Dienst abgeschaltet wird. Die Kombination aus High-Tech und Rückkehr des Mittelalters, die gerade in den USA entsteht, finde ich schon bemerkenswert.

Wie heißt es doch so schön:

„There is No Such Thing as ‚The Cloud‘ – It’s Just Someone Else’s Computers“.

Ein weiterer Grund, seine Daten auf den eigenen Geräten zu halten, ist, dass Firmen wie Meta, Google, Adobe und viele andere unsere persönlichen Daten zum Trainieren ihrer KI-Modelle nutzen. Wenn man dem bei Meta vor einiger Zeit schon widersprochen hatte, muss man es jetzt noch einmal tun, und zwar getrennt für Facebook und Instagram. Die Verbraucherzentrale gibt hier einen Überblick: „Meta AI“ bei Facebook, Instagram und WhatsApp – so widersprechen Sie | Verbraucherzentrale.de und hier: https://netzpolitik.org/2025/meta-ki-jetzt-widersprechen-oder-fuer-immer-schweigen/

Man darf sich hier aber nichts vormachen: Unsere Daten wurden schon lange zuvor abgeschnorchelt – dabei klammheimlich und rechtswidrig für das Training der vielen Ki-Modelle genutzt. Die gerade aufkommende Wunsch der Tech-Bros nach Abschaffung des Copyrights, spricht Bände.

Gleichzeitig ist die Auswahl an Open-Source-Anwendungen, die man selbst hosten kann, so enorm groß geworden, dass man für praktisch jede kommerzielle Cloud-Anwendung auch ein Open-Source-Pendant für den eigenen Server findet. Gleiches gilt für den Reifegrad der Anwendungen. Ein Immich Foto-Server kann heute ebenso viel wie Google Photos und der Speicherplatz ist nur durch die Größe der Festplatten im eigenen Server begrenzt.

Eine immer aktuelle Liste über die interessantesten und besten Anwendungen, die man selbst-hosten kann, findet man bei https://github.com/awesome-selfhosted/awesome-selfhosted

Wenn man Portainer nutzt, kann man diese URL unter Settings -> App Templates eintragen, die zahlreiche Anwendungen als fertige Docker-Container-Vorlagen enthält:

https://raw.githubusercontent.com/Lissy93/portainer-templates/main/templates.jsonCode-Sprache: JavaScript (javascript)Diese Dienste hoste ich selbst

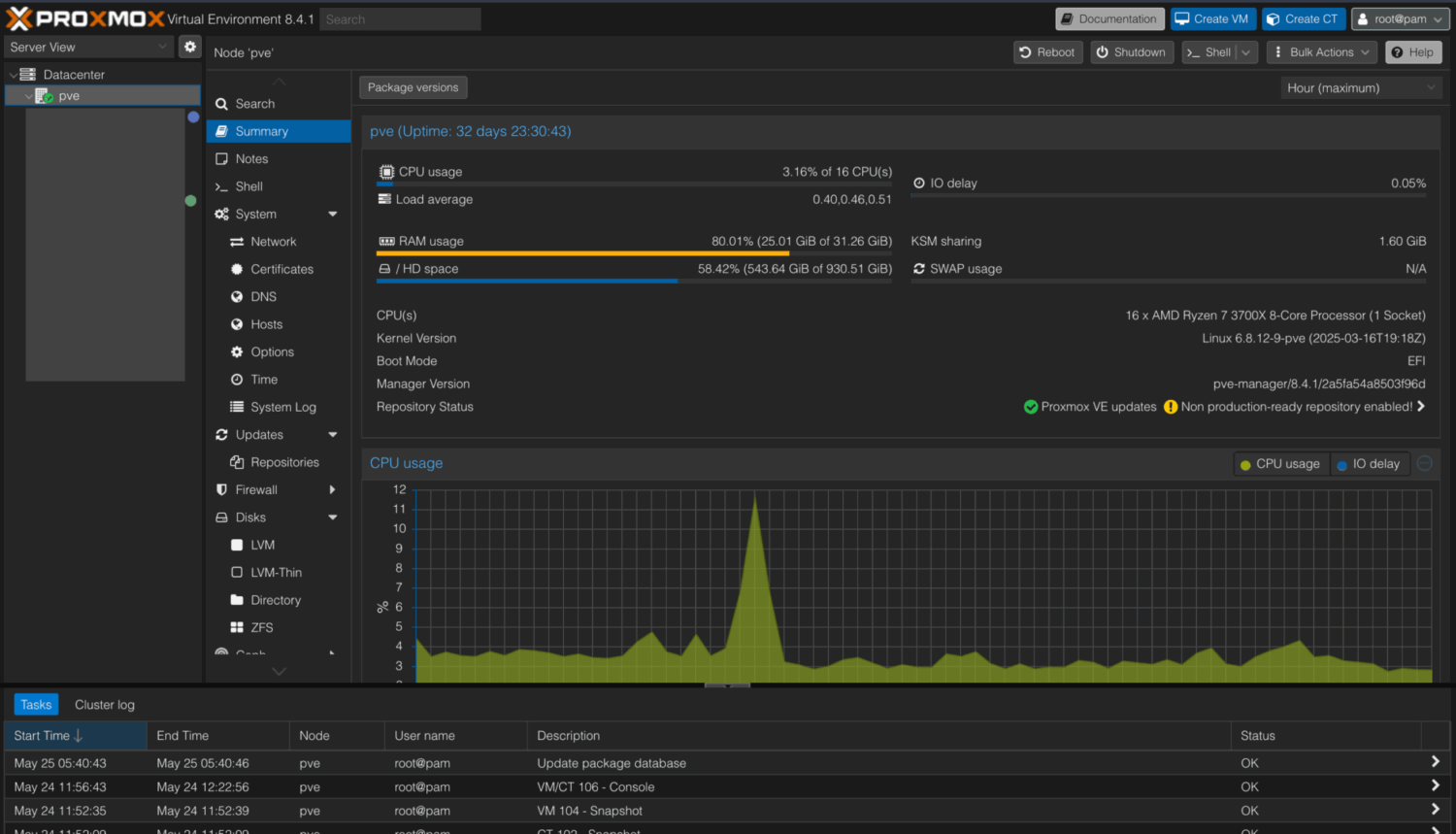

Ich betreibe seit 2017 einen Home-Server. Damals war OpenHAB als Smarthome-Steuerung die Hauptaufgabe des Servers, zusammen mit einem Fileserver auf Basis von Open Media Vault (OMV). Beide auf einer VMware ESXi Virtualisierung, die auf einem HP Microserver Gen 8 als Server lief. Dann kamen immer weitere Anwendungen hinzu und mit der Übernahme von VMware durch Broadcom – ebenfalls eine Lehrstunde in Enshittification – bin ich, mit einem Umweg über einen Unraid-Server, dann auf Proxmox umgestiegen.

Unraid tut übrigens auch viel dafür, um den Weg der Enshittification zu gehen. Zudem lohnt sich ein Unraid-Server meiner Ansicht nach nur, wenn als Hauptanwendung viel Festplattenkapazität benötigt wird – etwa für einen Mediaserver, also eher die NAS-Anwendung. Der Betrieb von Docker Containern und virtuellen Maschinen war bei mir unter Unraid immer etwas problematisch – besonders das Durchreichen von Hardware an virtuelle Maschinen z. B. zu Home Assistant.

Erst kürzlich habe ich dann den bisherigen Windows-Rechner aus meinem Tonstudio gegen einen Mac Mini M4 Pro ersetzt und die freigewordene PC-Hardware (AMD Ryzen 7 3700X, 32 GB RAM, NVMe- und SSD-Disks) wurde zum neuen Home-Server. Die altgediente Intel XEON E3-1230 v2 CPU des HP Microservers, war teilweise schon etwas zu schwachbrüstig für meine vielen Anwendungen. Der HP Microserver darf aber als Backup-Server und Hot-Spare für Home Assistant weiterlaufen.

Auf meinem Proxmox-Server laufen derzeit:

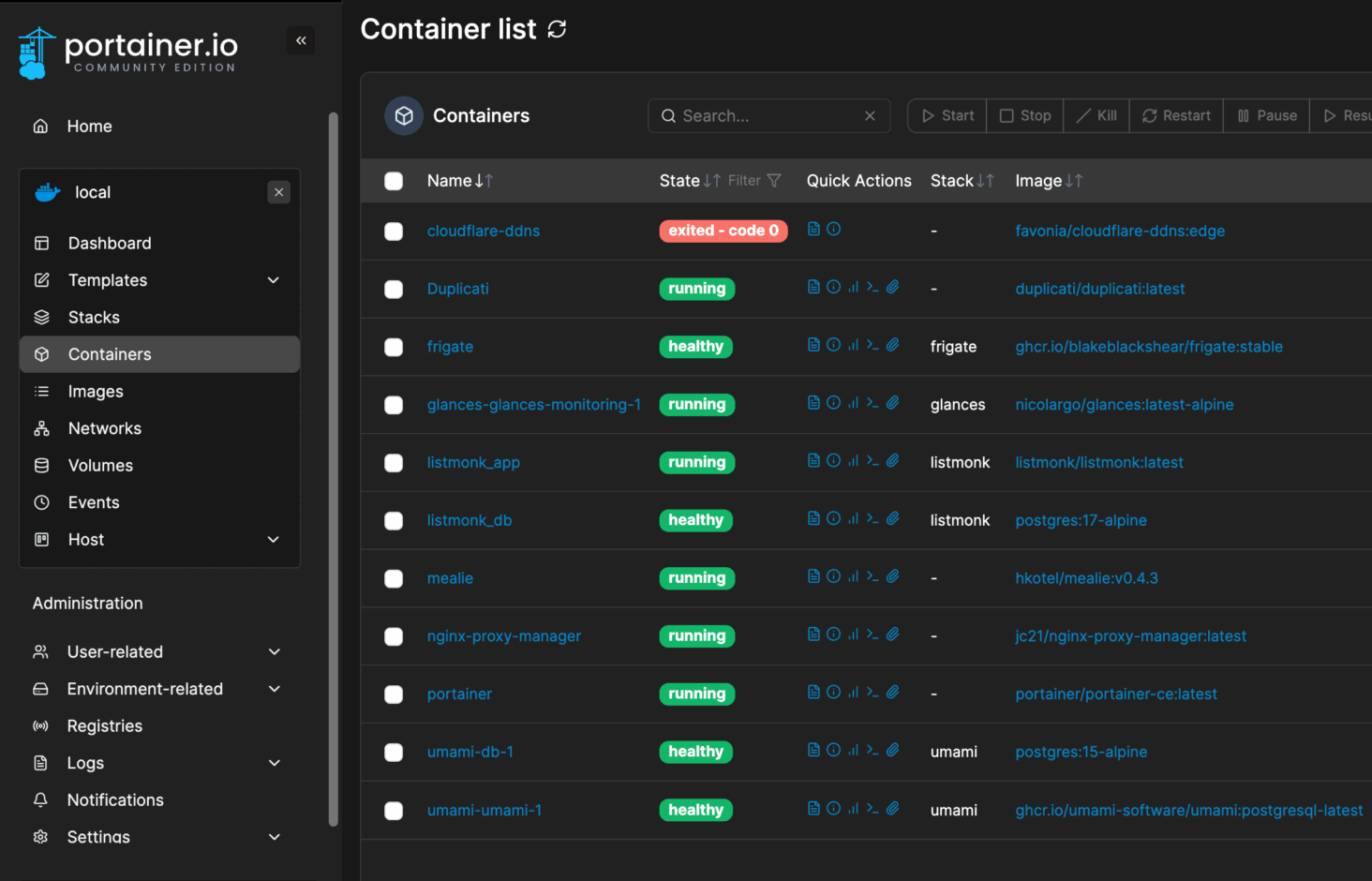

LXC-Container 1: Dienste, die nach außen gepublished werden

Auf dieser virtuellen Maschine werden diverse Docker Container bereitgestellt, die von außen erreichbar sein sollen. Sie stehen hinter einem Cloudflare-Proxy. Warum LXC-Container? Weil damit das Durchreichen des Google Coral USB TPU zuverlässiger und performanter ist, als bei einer VM. Ja, es gibt reichlich Diskussionen darüber, ob man Docker in einem LXC oder besser einer VM laufen lassen sollte. Im Home-Server-Bereich sehe ich dabei aber keine Probleme und hatte auch noch nie welche.

- Readeck – Bookmark und Read-It-Later Anwendung als Pocket-Alternative

- Joplin Sync-Server – für die Synchronisierung verschiedener Joplin-Clients. Warum nicht Obsidian? Weil es keine zuverlässige Sync-Lösung gibt, die man selbst hosten kann.

- Umami Analytics – Ersatz für Google Analytics

- Vaultwarden – Passwortmanager (Bitwarden)

- Frigate NVR – KI-Kameraüberwachung für Home Assistant (unterstützt durch eine Google Coral TPU)

- Immich – Alternative zu Google Photos

- FreshRSS – RSS-Reader als Alternative zu Inoreader und Feedly, welche absurd teuer geworden sind

- Portainer – zur Verwaltung dieser Docker Container

- Diun – Benachrichtigung über vorhandene Container-Updates

- Syncthing – Dateien per p2p Netzwerk synchronisieren

Virtuelle Maschine 1: Webdienste

- NGINX Proxy Manager – Reverse Proxy für Subdomains pro Dienst und Zertifikate

- PiHole – Adblocker fürs interne Netzwerk

- Glances – Server Monitoring

Virtuelle Maschine 2: Dienste, die nur intern erreichbar sind

- Paperless NGX – Dokumentenmanagement. Eine meiner unverzichtbaren, selbst gehosteten Anwendungen

- Paperless AI – KI-Suche über alle Paperless Dokumente, automatisches Tagging etc.

- Sterling-Tools – eine riesige Auswahl an PDF-Werkzeugen als Alternative zu Adobe Acrobat

- MeTube – YouTube Downloader

- Calibre Web – E-Book-Verwaltung

- Portainer – zur Verwaltung dieser Docker Container

- NodeRed – für ein paar Automatisierungspielereien, die in Home Assistant nichts verloren haben und früher auf einem Raspberry Pi liefen.

Virtuelle Maschine 3: Nextcloud

Nextcloud 13 mit diversen Apps. Darunter das Kochbuch, Mail, Collabora Office etc.

Virtuelle Maschine 4: Linux Mint –

Ein komplettes Linux mit Desktop, wenn ich mal ein Linux benötige.

Virtuelle Maschine 5: Windows 11

Für einige Dinge, die nur unter Windows laufen. Bedienung per Remotedesktop

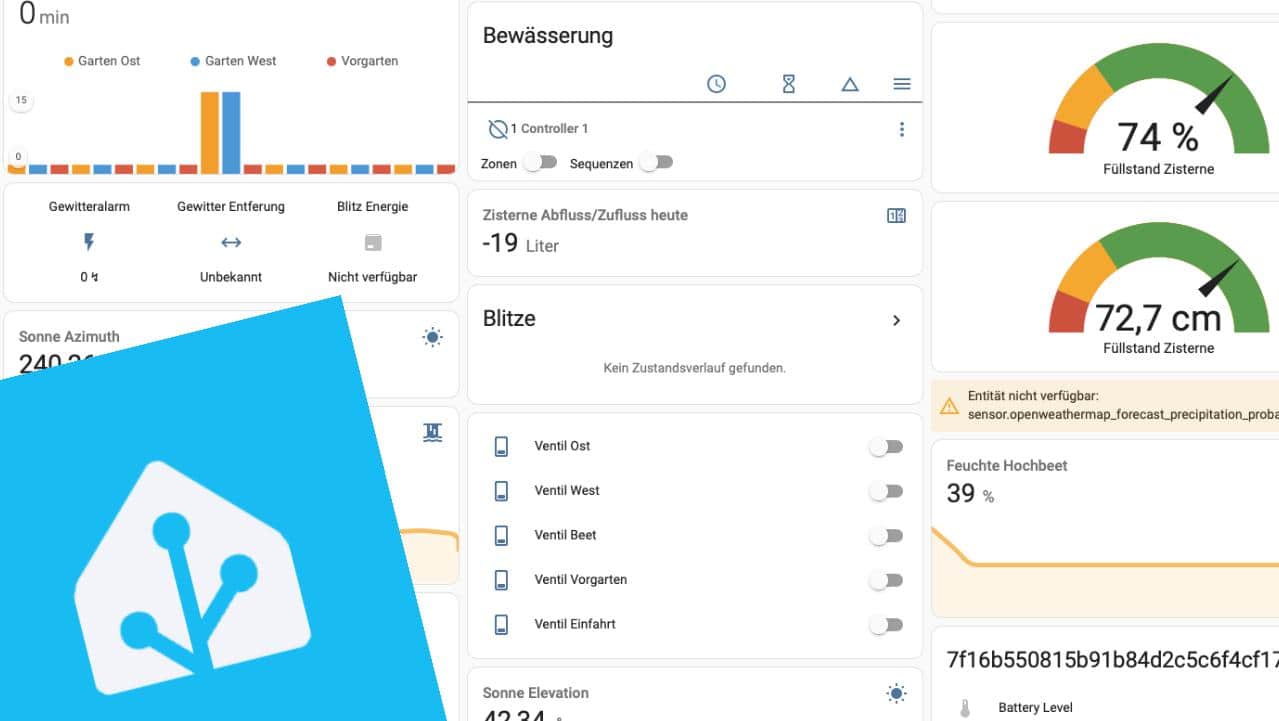

Virtuelle Maschine 6: Home Assistant

Eine virtuelle Maschine mit HAOS. Als Add-ons habe ich hier nur Dienste, die sehr nahe an Home Assistant arbeiten.

LXC Container 2: Docker für diverse Tests und temporäre Anwendungen

LXC Container 3: Proxmox Backup Server (PBS)

LXC Container 4: Turnkey Linux mit Samba Server

Da Netzlaufwerke bei mir nur eine Nebensache sind, habe ich nur einen einfachen Samba-Server in einem LXC Container laufen. Open Media Vault oder gar TrueNAS wären für meine Bedürfnisse vollkommen übertrieben, da ich keine Netzlaufwerke mit viel Speicherkapazität benötige (außer meinem Backup-Server inkl. Timemachine für macOS und Syncthing).

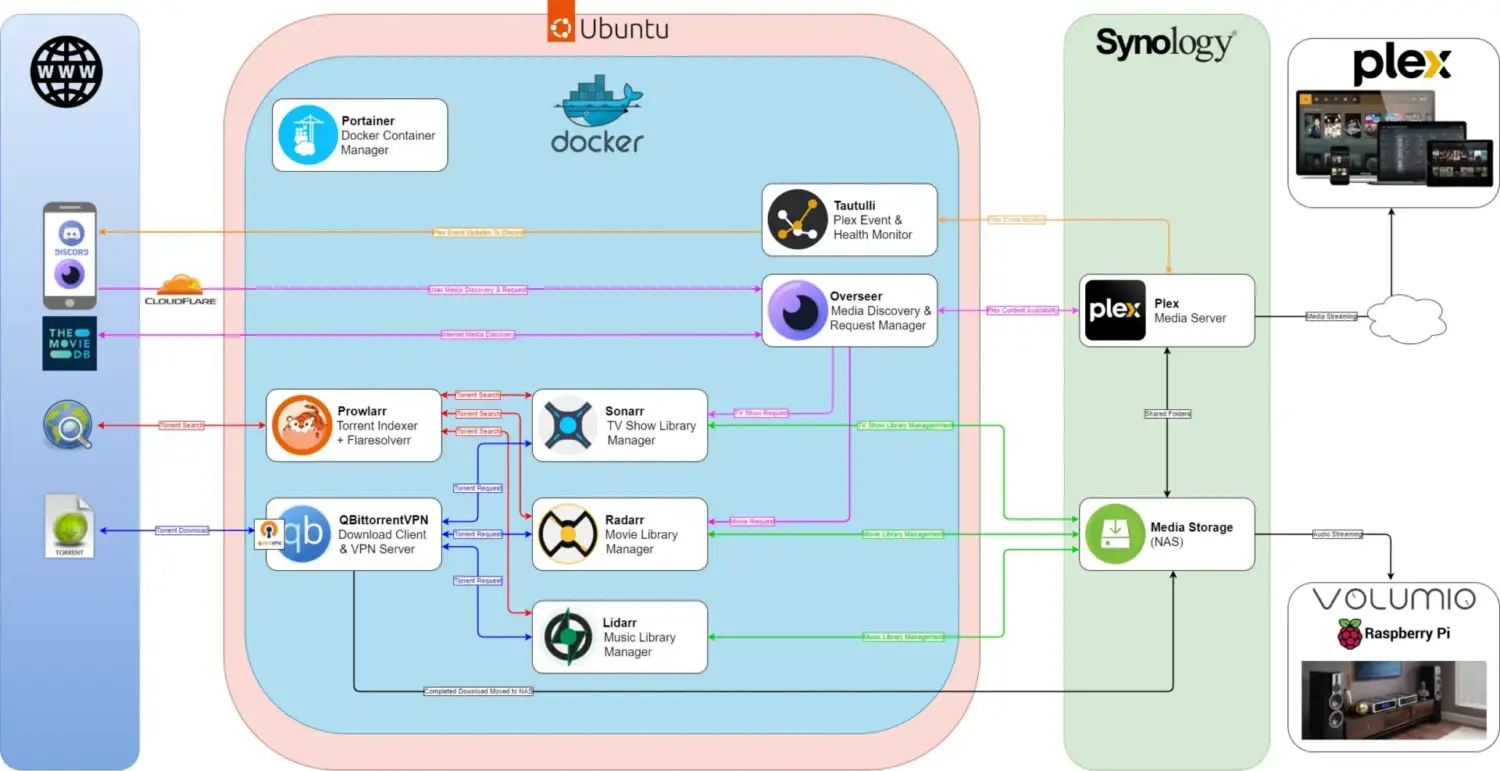

Vom Mediaserver zur universellen Lösung

Für viele war ein Mediaserver der Start ins Self-Hosting. Dafür habe ich keinerlei Verwendung, da ich mich nicht für Filme und Serien interessiere – zumindest nicht dafür, diese selbst zu horten.

Offenbar ist aber wieder ein Trend hin zu illegalem Downloaden von Spielfilmen und Serien zu erkennen. Die Leute sind es einfach leid, dass eine Serie nur bei einem bestimmten Streaming-Anbieter läuft und man erst einmal herausfinden muss, wer das ist. Viele sind auch nicht mehr bereit, für zig Streaming-Dienste zu zahlen, die nun auch immer mehr Werbung einschieben.

Selbst-gehostete Anwendungen wie der arr-Stack, also Bazarr, Prowlarr Lidarr, Radarr, Jellyfin etc. machen es einfach, illegale Inhalte zu finden und automatisiert auf den Server zu laden – inkl. VPN-Verschlüsselung. Einen guten Überblick bekommt man hier: https://github.com/geekau/mediastack und hier https://github.com/Rick45/quick-arr-Stack

Ich möchte euch damit nicht zum illegalen Download ermutigen. Man sieht aber auch hier, dass die Enshittification der Streaming-Anbieter dazu führt, dass sich technisch versierte Kunden, komfortableren Lösungen zuwenden. Dabei ist der Betrieb eines Home-Servers und die nötigen Zusatzdienste wie VPN, Filehoster wie Rapidshare, NZB Indexer etc nicht unbedingt günstiger. Es geht darum, die Dinge wieder selbst in der Hand zu haben und ernst genommen zu werden.

Neben der Funktion als Mediaserver und NAS sind heute eben viele andere Dienste selbst machbar und lassen sich bestens nebenbei betreiben – die Hardware ist ja schon da.

Home-Server – Aufwand vs. Nutzen und Gefahren

Natürlich ist es deutlich aufwendiger, einen eigenen Server zu betreiben. Neben den Hardware- und Stromkosten muss man sich um Updates und Backups kümmern. Man kann dabei aber auch viel lernen und ganz neue Möglichkeiten entdecken. Die Stromkosten fallen durch unsere PV-Anlage nicht mehr ins Gewicht, auch wenn der neue Server mit Netzwerkswitch etc. gut 120 Watt zieht.

Hier sollte man auch klein anfangen. Mein Setup ist mittlerweile schon ziemlich umfangreich und komplex. Wer ohnehin Home Assistant mit HAOS nutzt, kann mittlerweile viele Dienste – darunter sogar Nextcloud oder Paperless NGX – als Add-on in Home Assistant betreiben.

Ein Problem sind häufig Internetzugänge ohne eigene, feste IP-Adresse, was bei den meisten DSL- und Glasfaser-Anbietern der Fall ist. Wir sind derzeit noch bei einem regionalen DSL-Anbieter, bei dem eine feste IP dabei ist. Wenn der Glasfaseranschluss kommt, gibt es bei den privaten Tarifen nur dynamische IPs. Zuverlässige Abhilfe schafft Cloudflare DDNS.

Ebenso besteht immer eine gewisse Gefahr, wenn man Dienste nach außen öffnet. Das sollte natürlich niemals über eine Portweiterleitung im Router direkt zum entsprechenden Dienst erfolgen, sondern zumindest immer über einen Reverse-Proxy laufen (siehe oben: NGINX Proxy Manager oder auch Traefik).

Natürlich kann man viele Dienste auch auf einem V-Server z. B. bei einem Web-Hoster wie Hetzner, Strato etc. betreiben. Diese VServer gibt es schon für sehr wenig Geld und sie sind heute fast immer mit Docker ausgestattet bzw. dafür geeignet.

Eigener Mailserver? Besser bleiben lassen!

Ein eigener Mailserver, der auch wirklich als MX läuft, ist eine schlechte Idee – besonders bei einem Internetzugang mit dynamischer IP. Viele IPs von Internetzugangsprovidern sind durch Spammer, illegale Anwendungen etc. verbrannt und auf den Blacklists der Spamfilter, sodass eine Mail, die vom eigenen Mailserver versendet wurde, zu 100 % im Spamordner des Empfängers landet. Zudem sind die Anforderungen an Spamfilter beim Empfang so hoch, dass man einen selbst gehosteten Mailserver besser bleiben lassen sollte.

Was geht sonst noch?

Auf meinem Apple Mac Mini M4 Pro läuft ein lokales LLM, da ich im Hauptserver keine geeignete Grafikkarte habe und deren Verbrauch auf Dauer auch zu hoch wäre. Damit bleiben alle Daten, die ich an die KI übertrage, in meinem Netz und auf meiner Hardware. Derzeit greifen darauf die Joplin-Erweiterung Jarvis und NoteLLM zu. Auch Home Assistant ist daran angebunden und hört so auf komplexe Anweisungen. Der Mac Mini M4 ist hier recht potent, verbraucht wenig Strom und läuft ohnehin 24/7. Selbst das hervorragende Deepseek R1 32B Modell läuft auf dem Mac Mini erstaunlich gut und schnell. Allerdings entwickelt sich gerade qwen3:8b zu meinem Favoriten. Es hat eine gute Balance aus Größe, Geschwindigkeit und guten Ergebnissen. Als Basis nutze ich übrigens LM Studio statt Ollama.

Den Newsletter-Versand für nachbelichtet werde ich demnächst auch auf den Home Server umziehen. Mit Listmonk gibt es einen leistungsfähigen Newsletter-Manager, der per SES (AWS Simple Email Services) Newsletter versenden kann. Die jährlichen Kosten für Newsletter-Plugins für WordPress haben sich in 2 Jahren mehr als verdoppelt und es gibt praktisch keine wirklich guten kostenlosen Lösungen mehr, die auch SES beherrschen.

Außerdem sehe ich mir gerade n8n als Alternative zu NodeRed an, was für einige Automatisierungen, die sich nicht aufs Smarthome beziehen, interessant werden könnte.

Kein Backup – kein Mitleid!

Wenn man viele essenzielle Dienste selbst betreibt und die Daten dafür im Haus hat, ist eine Backup-Strategie unabdingbar. Nicht nur das regelmäßige Backup der Daten und Server-Konfiguration auf lokale Backup-Medien, sondern auch immer ein Backup außerhalb des Hauses. Ein Blitzschlag und Server, Festplatten und Daten sind futsch. Überschwemmung, Brand, Einbruch oder einfach Fehler bei Updates und Konfiguration, defekte Hardware und schon die Daten weg.

Ich nutze die Backup- und Snapshot-Funktionen von Proxmox und den Proxmox Backup Server, um lokale Backups zu erstellen, als auch Backups zu einer Hetzner Storage Box hochzuladen. Zudem gibt es zwei externe Festplatten, die an einem anderen Ort aufbewahrt werden.

Fazit

Nie war es einfacher, Anwendungen selbst zu hosten und damit den großen Tech-Konzernen den Mittelfinger zu zeigen. Docker und Container-Templates machen es leicht, neue Anwendungen zu installieren und zu aktualisieren. Voraussetzung ist natürlich ein flotter Internetzugang, am besten mit eigener IP-Adresse.

Dem gegenüber stehen Hardware- und Stromkosten sowie der Zeitaufwand für die Einarbeitung , Updates und Wartung. Wer also einfach Nutzer bleiben will, muss weiter den Cloud-Anbietern trauen und denen gegebenenfalls immer mehr Geld in den Rachen werfen. Hat man sich aber erst einmal etwas mit dem Self-Hosting befasst (und hat idealerweise schon Kenntnisse im Umgang mit Linux, Netzwerktechnik etc.) ist der Einstieg einfach.

Nie war es deutlicher und wichtiger, die Datenhoheit zurückzuerhalten. Das zeigen die aktuellen Entwicklungen aus den USA und wie blank Europa diesbezüglich dasteht. Zu wissen, dass man wesentliche Dienste selbst in der Hand und im Haus hat, finde ich nicht nur beruhigend, sondern ich bin auch etwas stolz darauf.

Schreibe einen Kommentar zu nachbelichtet Antworten abbrechen